J.B.Brown 医学研究科講師は、統計学的分析によって、人工知能(AI)の性能評価指標そのものの有効性を網羅的に検証し、分野を問わず正確にAIの性能を評価できる手法を世界で初めて開発しました。信頼性の高いAIの開発に加えて、ビッグデータを用いた創薬研究や治療法の創出などに貢献することが期待されます。

本研究成果は、2018年2月14日付で米国の科学誌「Molecular Informatics」に掲載されました。

研究者からのコメント

Brown講師

AI開発は日々ニュースに出ており、研究だけではなく社会の変化を導いています。AIが開発されたと聞くと、私たちはどのような印象を持てば良いでしょうか。また、報告されるAIの本当の性能はどこにありますでしょうか。本研究は、AIの性能評価指標そのものの有効性を評価したもので、今後AIを開発する前に性能評価指標として何が適切であるか事前に調査する手法ができ、一般公開しました。開発依頼元が性能条件をこの手法により決定し、依頼先に条件を指定でき、より堅牢なAI開発につながると期待しています。

概要

AIによるビッグデータ解析は、医療現場や市場分析など社会のさまざまな分野での活用が進み、今後さらなる普及が予想されています。また、創薬研究などで分子モデルの有効性を予測する場合にも、AIは主要な検証手段として重視されています。しかし、例えば特定の分子を検出する場合に、実験における検出成功率が、コンピューターモデルによる事前予測を大きく下回るという事例がしばしば報告されています。その根本的な原因は、コンピューターモデルすなわちAIの性能を過大に評価した統計的指標にあると考えられます。これまでは、AIの性能評価指標としてTPR(True Positive Rate:真陽性率)とACC(Accuracy:正確率)をはじめとする数種類の指標が用いられてきましたが、これらの指標は本当にAIの性能を正しく評価できていたのでしょうか?

本研究では、AIの性能を統計的指標によって正確に評価する手法を開発しました。この手法は、TPRやACCなど各指標の特性と有効性を、分布関数(iCDF)を使った統計学的な解析によって検証するものです。検証の結果は、AI技術に関わらずに、TPRやACCなどでの高評価値を得られる確率が高く、実応用の有効性につながらない可能性が高いことを示しました。さらに、AIの開発と評価実験を行う前に、新手法によって評価指標そのものの特性を十分に吟味するべきであることが分かりました。社会に浸透しつつあるAIも、その情報の正確性を評価した上で有効利用することが必要不可欠といえます。

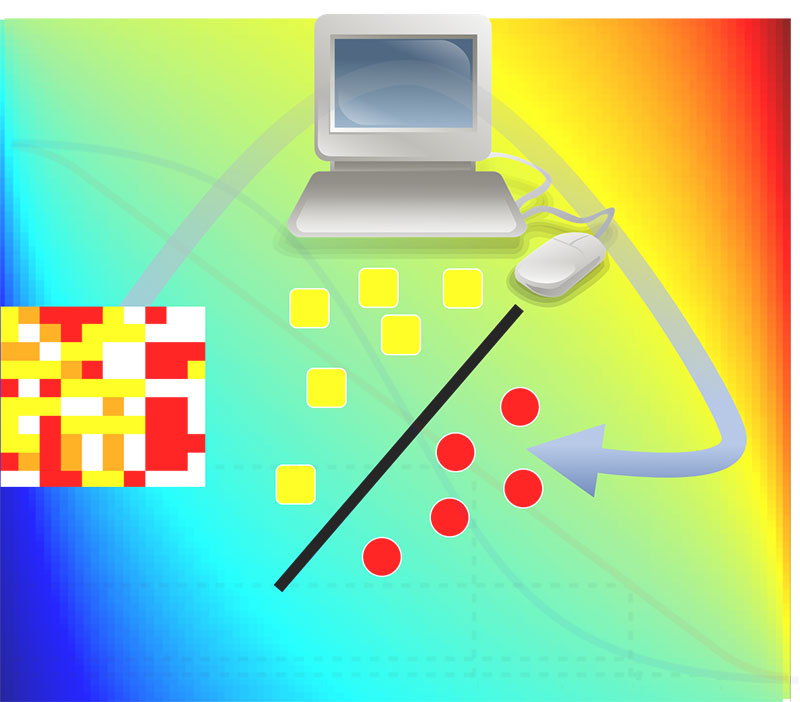

図:AIの中には、例えば「薬効があるか否か」のような二項予測問題が多い。AIを評価するには評価指標を用いるが、データの性質と指標によって過剰に評価してしまう可能性がある。今回開発した新手法は、AIを開発する前に予想対象のデータ特性によって評価指標そのものの妥当性を評価することを可能にするものである。

詳しい研究内容について

書誌情報

【DOI】 https://doi.org/10.1002/minf.201700127

【KURENAIアクセスURL】 http://hdl.handle.net/2433/229499

J. B. Brown (2018). Classifiers and their Metrics Quantified. Molecular Informatics, 37(1-2), 1700127.

- 日刊工業新聞(2月28日 30面)および日経産業新聞(3月1日 5面)に掲載されました。